L'informatique Invisible: Une 4ème révolution ?

On parle actuellement du Metavers et sur le web 3.0 mais il s'agit principalement des contenus. L'informatique Invisible est en revanche le média révolutionnaire qui permettra d'y accéder. Il ne s'agit pas seulement d'un accés immersif grâce à la réalité mixte/virtuelle/augmentée, mais aussi de la disparition annoncée du hardware de papa.L'informatique Invisible: Définition

"Invisible Computing" est un terme inventé par Don Norman, un des apôtres US de la tech, qui dans un livre de 1998, "Invisible Computer" déclare, reprenant et transformant la devise de l'Exposition universelle de Chicago 1933 "La science trouve, l'industrie applique, l'homme se conforme", en "Les gens proposent, les sciences étudient, la technologie se conforme", pour lui emblématique du XXIe siècle.

"Les technologies ont un cycle de vie...", déclare toujours Donald Norman, "...et les entreprises et leurs produits doivent changer à mesure qu'ils passent de la jeunesse à la maturité. Hélas, l'industrie informatique se croit encore dans son adolescence rebelle, exultant de complexité technique. Les clients veulent du changement. Ils sont prêts pour des produits qui offrent commodité, facilité d'utilisation et plaisir. La technologie doit être invisible, cachée à la vue."

Norman montre pourquoi l'ordinateur est si difficile à utiliser, et que cette complexité est de nature fondamentale, très difficule à changer. Le hiatus entre les générations en est un bon exemple, par le fait que de nombreuses pesonnes agées passent directement à la tablette ou au smartphone bien avant de toucher un ordinateur, pourtant plus proche de leur génération.

La seule réponse selon Norman, est de recommencer à zéro, développer des appareils d'information correspondant réellement aux besoins et à la vie des gens. Pour ce faire, les entreprises doivent changer leur façon de développer ces produits, en commençant par comprendre les usages gens. Les besoins doivent primer, et la technologie doit être à son service, l'inverse de ce qui se fait actuellement.

Dans ce sens, l'"informatique invisible" est plutôt un changement d'attitude général, une philosophie, plutôt que la traduction de cette préoccuptation de manière plus concrête. Les premiers temps de l'informatique, dirigées par les géants du hardware que sont Microsoft et Apple, un temps des pionniers, est devenu un rente technologique avec peu d'incentives pour proposer de réels progrés technologiques. Leur passage à Wall street et comme trop souvent, une réappropriation des assets par des financiers, ont tué l'incentive technologique pour le profit à court terme sous couvert d'une habile communication et d'un marketing bien rôdé, rendant captif particuliers et entreprises.

Après tout on achête bien, près de quarante ans après le même combo PC-Tour + Clavier + Souris + Ecran. Le prototype était même le Xerox Alto, en 1973 (l'année de ma naissance :)). Ce qui fait pratiquement un demi-siècle !

La révolution du tactile

Or, il semble y avoir eu plus d'innovation dans un secteur comme l'aviation ou la médecine, que l'informatique personelle ou professionelle. Le premier "dynamitage" à eu lieu lorsqu'Apple, sous la houlette de Steve Jobs, qui s'est toujours déclaré pour une ligne "user-friendly" au coeur de sa philosophie, à présenté son Iphone avec un écran tactile en 2004. C'est ce dernier qui à montré que malgré un OS assez proche de ce qui existait déjà en informatique (des dossiers et fenêtres), on pouvait utiliser une surface tactile pour remplacer la souris et le clavier (virtualisés).De nos jours un Smartphone de dernière génération comme le samsung 10 à plus de puissance (7 Ghz pour le Samsung S10) qu'un ordinateur de bureau moyen dix ans plus tôt, et tient dans la poche. On peut déjà effectuer un grand nombre de tâches depuis son ce dernier, certains métiers en dépendant même totalement, et la jeunesse l'ayant adopté et déserté le PC. L'ordinateur classique devient ainsi graduellement un "troisième choix" derrière la tablette, qui a aussi su s'imposer avec les mêmes recettes, mais pour un gabarit supérieur.

La révolution du cloud computing

Certes, pour la plupart des gens, le cloud computing n'est qu'un service d'hébergement à la base: On peut s'en servir pour stocker des sites web, de la documentation, des logiciels, et y créér un espace de travail collaboratif complet, disponible partout avec une big data actionable, créant de la valeur ajoutée. Le Cloud Computing (en bon Français "infonuagique") c'est une croissance à 2 chiffres, avec un CA de 380 Milliards de dollars estimées en 2022 (210 en 2019 - src journal du net).

Le COVID 19 aura montré les avantages et limites d'une "enteprise virtualisée", avec des salariés confinés chez eux, découvrant le télétravail et ses outils. Or, le cloud computing à des ressources insoupçonnées: Si on peux virtualiser un ordinateur à distance, pourquoi ne pas utiliser, à l'endroit ou l'on se trouve, un simple "terminal" pour accéder à cet ordinateur à distance.

Pour résumer, on parvient à utiliser la mémoire et des capacités de calcul à distance ainsi qu'un réseau partout à travers le monde. Ce qui permet, au lieu d'avoir une tour ou un laptop énergivore (qui surchauffe et dont les performances laissent souvent à désirer), de sortir de sa poche un simple boîtier modem.

La solution KVMC

Ce dernier produit n'existe pas, mais on peut s'en faire une idée avec un mini-ordinateur comme le raspberry pi connecté à un clavier flexible, et ensuite connecté à un écran traditionel (un ipad ça marche aussi !). Bref, il faut un minimum de hardware quand même, le "KVM" (Keyboard-Video-Mouse) +Cloud.Mieux encore, le concept de "double projecteur", un des deux affichant un clavier virtuel et l'autre projetant l'écran virtuel de travail au mur. Le hardware est assez petit, avec juste assez de composants pour servir de modem. L'utilisateur peut de fait se connecter à son poste de travail à distance sans se soucier des performances matériels ni de ses données, stockées à distance. Fini le temps du PC qui prends l'eau, surchauffe, ou est victime d'une panne quelconque, obligeant à courir chez le réparateur pour recouvrir ses précieuses données en même temps que son outil de travail !

Sur le papier cette solution, le "cloud based virtual Machine" (CBVM) est séduisante, mais si à ce jour, est proposée par les "grands" de l'informatique, sur le marché de cloud (Comme Amazon WS, Mic. Azure, Google Cloud, ou OVH en Europe), l'accés reste "classique" (laptop par exemple) et personne n'a pensé à proposer ce genre de hardware. Une autre problème de fond est La qualité de la connection internet. Toutefois en mutalisant la ressource informatique, des gains considérables d'économies d'énergie seraient réalisées, pour un vrai bonus écologique. Pas étonnant que les entreprises se ruent dessus.

La révolution de l'IA

L'Intelligence Artificielle ? - Une fumisterie !. Beaucoup d'experts de la tech qui la voient appliquée à l'interface homme-machine (comme les malheureux chatbots des années 2000) se désespèrent de son manque de progrès. Certes, on peut domestiquer un IA pour battre le champion mondial du Jeu de Go, mais avec beaucoup d'optimisation et une véritable équipe derrière.

D'autres applications où l'IA se montrerait vraiemùent polyvalente et irai comme un gant à la nouvelle génération de robots en développement n'est pas prête d'arriver.

Pourtant il existe une variante bien moins complexe et réalisable, également délaissée par les grands de l'informatique: L'IA de travail auto-apprenante ("self-learning working IA" ou SLWOIA). Il s'agit d'une IA qui se contente d'imiter l'utilisateur/trice dans ses tâches quotidiennes, apprenant les usages. Quelle utilité ? - Remplacer l'humain pour des tâches répétitives à faible valeur ajoutée, mais virtuelles, ce que les robots première génération font dans le monde réel.

Outre cette prise en charge automatisée (qui existe en bribes, come le script d'adobe photoshop pour des gestions d'images en masse par exemple), l'IA doit faire preuve un minimum d'apatation, n'étant pas plus autonome qu'un jeune enfant. Il existe des "gadgets" qui s'en rapprochent comme le sytème Cortana chez Microsoft, mais aussi Akexa et Siri, les fameux "assistants personnels" de nos chers smartphones, utiles pour l'instant à des actions et recherches simples, certes en mode audio, plus naturel.

Mais imaginez comment une IA pourrait simplement prendre en charge toutes ces tâches, souvent compartimentalisées dans des logiciels différents, et donc imposant des manipulations et conversions, ainsi que surmonter trop souvent des problèmes d'incompatibilité. Une IA auto-apprenante et adaptable, permettant à l'humain de jouer ses points forts dans la créativité, mettant de côté le "daily grind", et libèrerant in fine ce précieux "temps de qualité" derrière lequel nous courront tous.

Metavers et lentille optique: Le monde 4.0

Travailler en réalitée immersive

Une des évolutions du cloud, toujours du point de vue du hardware, pour se passer complètement d'un clavier et écran projetés, est l'usage de la réalité virtuelle et augmentée, ou "mixte". Je ne vais pas m'épancher sur ce domaine, déjà épuisé ad nauseam sur ce site, mais avec le recul de quelques années, il apparaît maintenant clair que le grand public n'est toujours pas conquis, pris dans un perpétuel cercle vicieux "peu d'utilisateurs > peu d'incentive à créér du contenu"; et la perception de gadget dans l'opinion publique maintenant lassée de l'effet nouveauté.

Les technologies immersives se sont imposées graduellement en revanche dans le monde professionnel, trouvant de vraies application de niche dans de nombeux secteurs. Mais dans l'absolu, il manque pour cette rencontre avec le grand public cette "fonctionnalité indispensable" pour s'imposer. Après tout un smartphone est avant tout un téléphone...

Le problème du casque de réalité virtuelle ou mixte actuellement est qu'il 1- côute un bras, et l'ordinateur compatible 2- coûte aussi très cher. Tout ça pour quelques rares applications dont on fait le tour en deux jours. Peu séduisant pour un développeur qui espère une croissance ou des écononomies d'échelles pour rentabiliser son travail. De plus les matériels évoluent vite et certains des appareils sortis en 2017-2018 sont maintenant des pièces de musée.

Un autre problème relevé par les "early birds" essayant de travailler avec l'OS win 10 en réalité virtuelle, notamment avec Microsoft HoloLens se sont retrouver face à des applications 2d clairement tirées de l'OS classique, et l'OS n'offre l'avantage que plus d'espace de placement des "boîtes" 2D de se programmes, dans la limite du FOV (champ de vision). En travail d'entrepise en équipe, un collaborateur qui travaille longtemps en réalité virtuelle aura du mal à ne pas voir son environnement immédiat, entendant des personnes discuter, passer, des choses arriver tout en étant exclu de cette réalité.

C'est au final malpratique. Il faudrait que Microsoft "réinvente" ses logiciels traditionnels pour les adapter à une utilisation en réalité mixte (on voit toujours son environnement et les personnes autour dans ce cas), mais le même cercle vicieux de trop peu d'utilisateurs refait surface et les gestionnaires regardent les chiffres proches, pas lointains. Au final, en attendant les lunettes Apple et la réponse des autres géants cette année, le paysage n"évolue par beaucoup sinon sur un consensus que les lunettes futures devront pour voir procurer de la réalité mixte, augmentée et virtuelle dans un seul produit.

Le coeur de l'informatique invisible: Remettre l'humain au centre

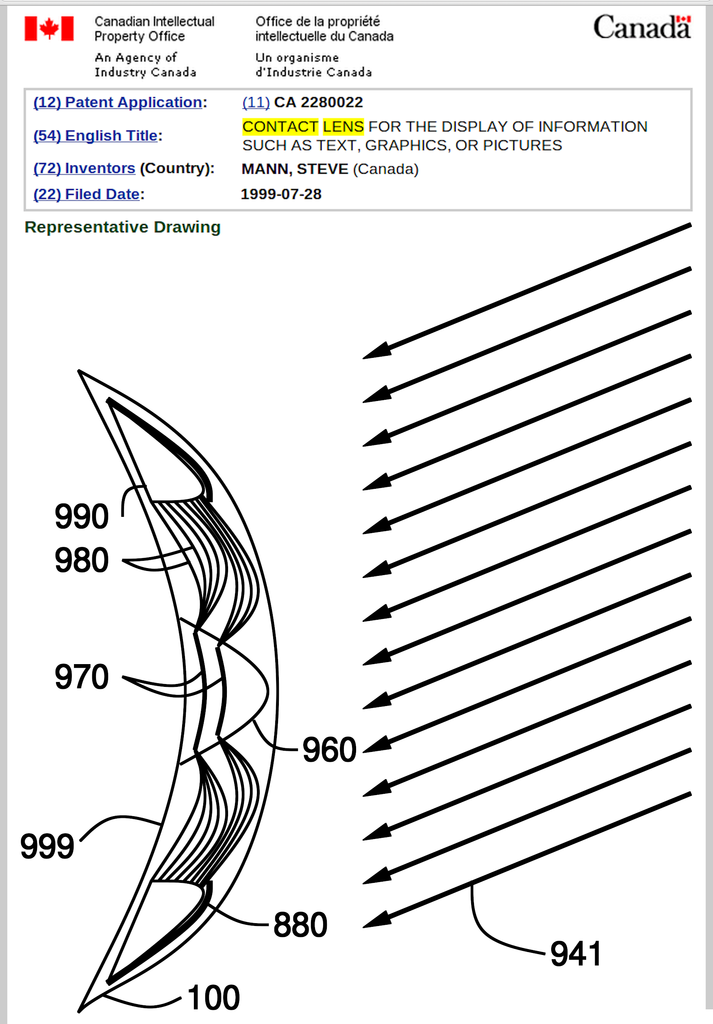

Brevet Canadien de "lentille bionique"

Comme disait l'auteur à succés de SF Arthur C. Clarke, "toute technologie suffisamment avancée est indiscernable de la magie". C'est sans doute le cas du système le plus ambitieux à ce jour, possible avec la miniaturisation à outrance: Et si le sens le plus solicité en informatique, la vue, devenait le média principal ? Aujourd'hui, le nouvel enfant chéri des transhumanistes Américains, c'est la lentille optique. Première expression d'un futur plus si éloigné, de l'"homme augmenté", et parfaite illustration de l'être cyberpunk du XXI siècle.

La lentille optique, c'est l'idée d'avoir juste suffisamment de hardware pour projeter des informations devant vos yeux, et actionnable avec la voix, les mains et naturellement, la vue. Il est impensable d'avoir l'intégralité d'un ordinateur puissant tenant place sur une lentille optique pour l'instant, et donc le hardware serait soit, semblable à un smartphone en poids et taille, tenant dans la poche, et connecté à la lentille, ou bien en cloud, avec l'antenne intégrée à la lentille capable de se connecter en 5G/6G.

Il y a de nombreux acteurs dans le monde qui se sont penchés sur la question, notamment des Français. Le leader mondial actuallement, c'est Mojo Vision. Pour résumer leur philosophie le mieux est encore de citer leur site internet et la définition traduite de l'informatique invisible (2020).

Chez Mojo, nous aimons nos écrans grands et petits, dans nos mains et sur nos bureaux. Mais nous détestons qu'ils nous éloignent de nos vies en perturbant notre journée. Ils peuvent fournir des informations cruciales sur les personnes, les événements et les environnements que nous rencontrons, mais ironiquement, ils nous distraient du monde qui nous entoure tout en fournissant ces données. Vous ne pouvez pas regarder vers le haut et vers le bas en même temps.

Avec sa capacité à superposer des données et des graphiques essentiels sur notre monde, la réalité augmentée (RA) ressemble à l'avenir. Pourtant, à ce jour, personne n'a résolu le problème du matériel discret. On nous dit que nous devons porter des lunettes AR encombrantes, lourdes et gourmandes en énergie qui sont si visibles et socialement gênantes qu'elles nous font paraître presque extraterrestres. Le plus gros problème avec les appareils et les lunettes AR est peut-être qu'ils perturbent les interactions les plus importantes de notre époque, celles que nous avons face à face avec d'autres personnes. Porter des lunettes lors d'une réunion ou regarder constamment vers le bas vers votre appareil ou portable peut vous donner l'impression d'être mal à l'aise, désintéressé ou, pire encore, indigne de confiance.

Nous nous sommes donc demandé : et si nous pouvions fournir des données directement au champ visuel de quelqu'un et faire disparaître tous ces appareils et casques ? Nous pouvions aider les gens à rester engagés dans l'instant, sans jamais avoir à détourner le regard de la route ou des personnes devant eux. Ils pourraient entrer dans n'importe quelle conversation ou situation informés et prêts, sans la stigmatisation des lunettes ou d'un casque qui ne les laisse pas ressembler à eux-mêmes. C'est ainsi qu'est née l'idée derrière la plateforme Invisible Computing.

L'informatique invisible est le pouvoir de déplacer notre attention de la technologie vers le monde qui nous entoure. L'informatique invisible peut également être contextuelle, détectant ce qui nous entoure en nous aidant à réagir de manière dynamique et à emporter librement des informations et des idées avec nous partout où nous allons. Nous pouvons rester connectés avec notre monde, notre environnement et nos communications, le tout sans la distraction d'un appareil. L'informatique invisible a le pouvoir de rendre nos interactions avec les gens et les lieux plus intuitives et adaptées en faisant disparaître la technologie. Depuis la création de Mojo Vision à la fin de 2015, notre équipe multidisciplinaire de scientifiques, d'ingénieurs, de concepteurs, d'experts médicaux et de chefs de produit de classe mondiale a été à l'avant-garde de nouvelles technologies pour prendre en charge la plateforme Invisible Computing. Nous sommes enthousiasmés par la possibilité de faire ce qu'aucun autre produit n'a fait à ce jour : transformer nos interactions constantes avec les appareils en connexions plus profondes et meilleures les uns avec les autres.

Nous avons des expériences d'idées révolutionnaires à partager avec vous dans les semaines et les mois à venir, alors restez à l'écoute.

Sources

The Invisible Computer, Donald A. NormanWhat is Invisible Computing? (Mojo)

Nouvelle méthode pour lentille - Univ. Purdue

Exemple de clavier virtuel pour smartphone

Windows_Mixed_Reality

invisible-computing: medium.com

Piqo Projecteur

Projecteur mural avec smartphone

Videos

Virtually Speaking: What is Virtualization?Achat nouvel ordi/vs Azure Cloud

Qu'est-ce que le Cloud Computing ? (JirAWS)